Analyse de logs

Dans le cas des robots, l’analyse de logs nous permet de savoir quelles pages ont été crawlées (ou ne l’ont pas été), à quelle fréquence, les codes HTTP reçus mais aussi de différencier les crawls mobile et desktop (grâce à l’information sur le user-agent). Par la suite cela permettra de détecter des erreurs critiques et/ou de réaliser des améliorations !

Applications

Les logs enregistrent toute l’activité reçue par le serveur sur lequel un site Web est hébergé. Chaque fois qu’un utilisateur accède à un site Web, il fait une demande au serveur.

Pourquoi l'analyse de logs est intéressant ?

Les logs nous fournissent de nombreuses informations : adresse IP, heure de la requête et fuseau horaire du serveur, type de demande, statut de la réponse HTTP ou encore le user-agent par exemple.

En croisant les données récoltées avec les données issues d’un crawl “classique”, on peut comparer le site tel qu’il est, comparé avec la “vision” du robot de Google, en faisant ressortir des indicateurs tels que le taux de crawl du site par Google (nombre de pages crawlées / nombre total de pages), la fenêtre de crawl (temps passé entre 2 passages), etc… Il est aussi possible d’identifier les pages orphelines qui n’apparaissent pas dans le crawl (mais qui peuvent être présentes dans les logs car elles sont connues de Google au cours d’un crawl précédent), par conséquent le robot continue de les crawler même si elle n’est plus accessible au cours d’une navigation normale sur le site web.

Pourquoi l'analyse de logs est intéressant ?

L’analyse de logs peut aussi être utile avant et après une refonte de site, on peut observer la différence de comportement des robots entre les deux “versions” pour identifier si le maillage est toujours aussi efficace qu’avant la refonte, comparer le temps de chargement des pages ou encore détecter des problématiques techniques comme des redirections ou des erreurs.

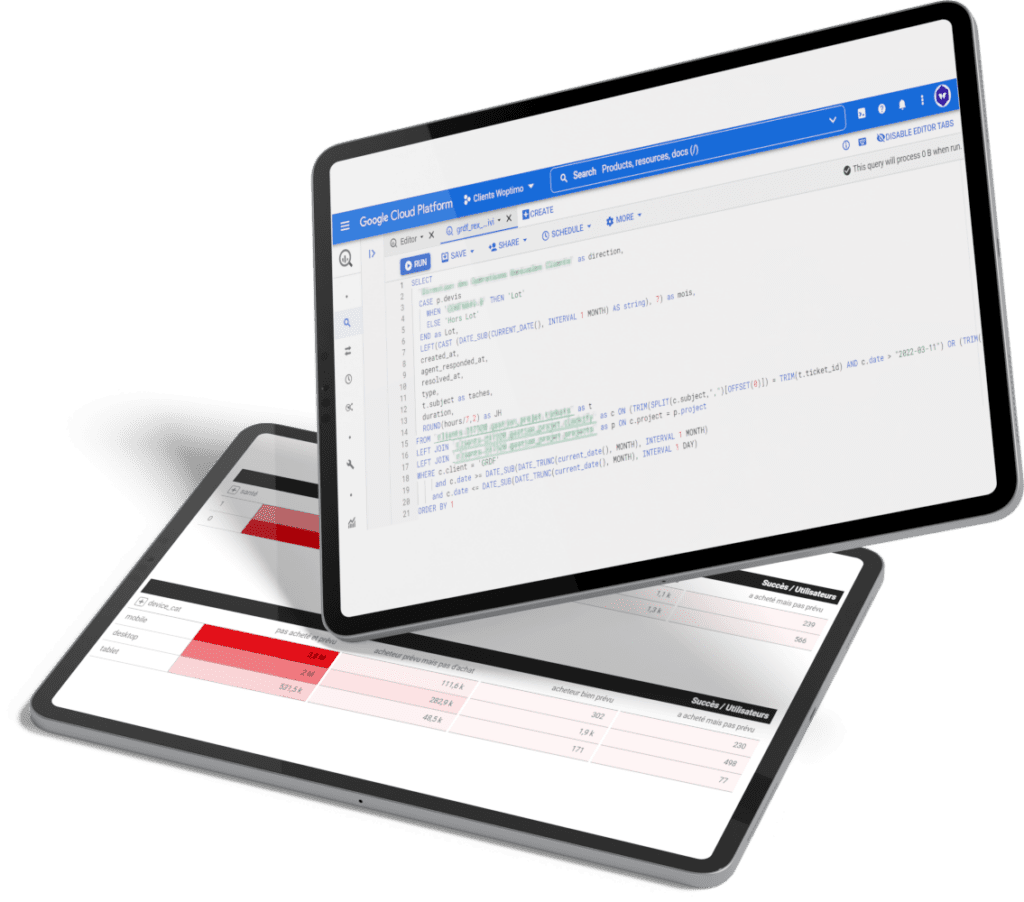

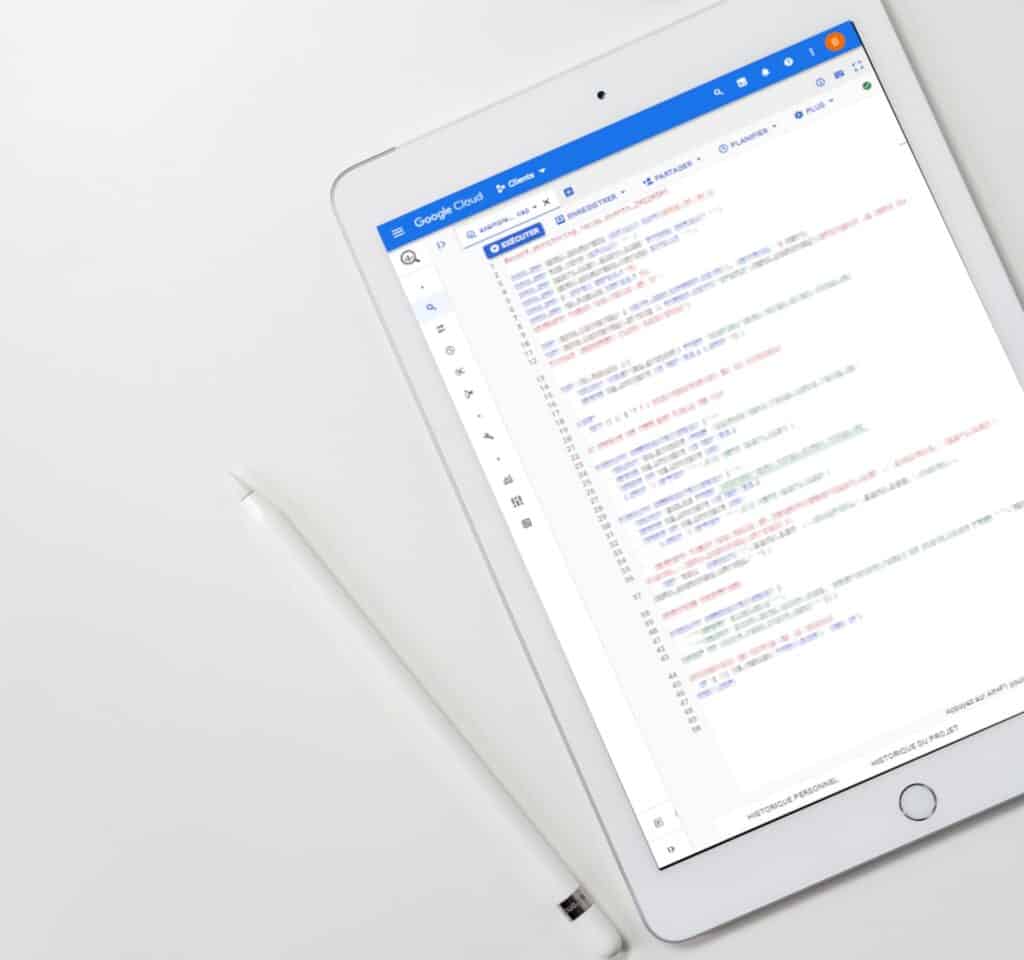

Toutes les données doivent être centralisées sur une même plateforme (dans notre cas sur GCP) afin de pouvoir les analyser et en faire ressortir des indicateurs de performance intéressants afin de les présenter au sein d’un outil de reporting tel que Google Data Studio.

Comment fonctionne l'analyse de logs ?

Google crawle de préférence les pages qu’il considère importantes, ce n’est pas le cas de tous les crawlers, mais, il est probable que les pages les moins crawlées le soient pour diverses raisons, qu’il faudra identifier : linking interne, trop de profondeur ou encore contenu faible, URL dupliquées…

Pour l’exploration d’un site via les robots, les moteurs de recherche allouent quotidiennement un nombre maximum de requêtes. Avec les logs il est possible d’avoir une idée approximative du budget alloué pour les robots, à chaque visite de votre site (budget crawl) et ainsi optimiser les prochaines visites (par exemple si on s’aperçoit que des pages sans objectif de positionnement ont été crawlées alors que des pages plus importantes ne l’ont pas été).

On travaille ensemble ?

Notre expertise Analyse de logs nous permet de vous aider à être plus efficaces grâce à l’exploitation de vos données. Nous transformons et donnons du sens à vos données pour vous aider dans la prise de décisions et mettre en place les actions marketing les plus pertinentes.

- Adresse : 4 boulevard de Strasbourg, 75010 Paris

- Téléphone : +33 1 88 32 18 20

- Email : [email protected]